OpenAI представила GPT-5.3-Codex-Spark: скоростной ИИ для кодинга

Компания OpenAI анонсировала выпуск GPT-5.3-Codex-Spark — уменьшенной версии своей флагманской модели GPT-5.3-Codex, оптимизированной для работы в реальном времени. Новая модель способна генерировать более 1000 токенов в секунду.

Особенности GPT-5.3-Codex-Spark

GPT-5.3-Codex-Spark работает на специализированном чипе Cerebras Wafer Scale Engine 3, а не на GPU. Это первый результат партнерства OpenAI и Cerebras, о котором компании объявили в январе. Идея Spark — дополнить старшую модель, а не заменить ее.

Производительность и возможности

GPT-5.3-Codex предназначена для длительных автономных задач, где агент может работать часами и днями. Spark, наоборот, рассчитана на быстрый интерактивный цикл: точечные правки, рефакторинг логики, итерации над интерфейсом с мгновенной обратной связью.

- Генерация текста ускорена в 15 раз

- Время до первого токена сокращено на 50%

- Задержка на каждый запрос — на 80% благодаря переходу на постоянное WebSocket-соединение

Точность и сравнение с аналогами

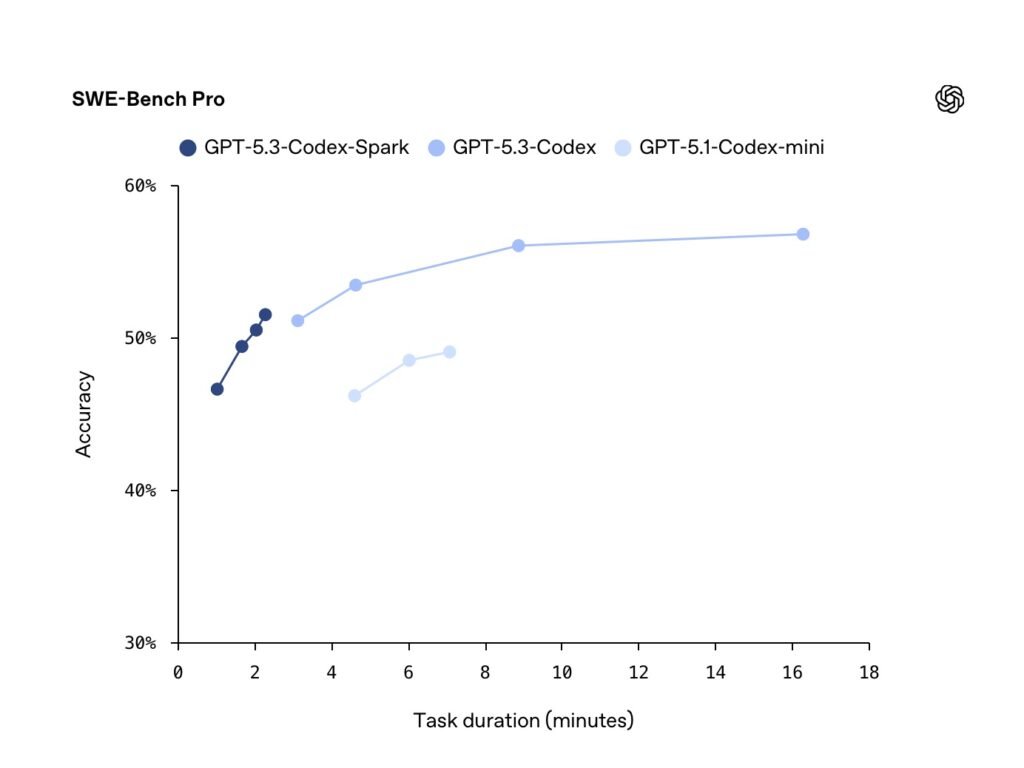

На бенчмарке SWE-Bench Pro Spark набирает около 52% за 2–3 минуты, тогда как старшая GPT-5.3-Codex достигает ~57%, но тратит на ту же задачу до 16 минут. На Terminal-Bench 2.0 разница заметнее: 58,4% у Spark против 77,3% у флагмана.

Доступность и перспективы

Codex-Spark доступна в режиме research preview для подписчиков ChatGPT Pro — в приложении Codex, CLI и расширении VS Code. Контекстное окно — 128 тыс. токенов, пока только текст, без изображений. OpenAI также открыла доступ к модели через API для небольшой группы партнеров.

По мнению Cerebras, релиз открывает принципиально новые паттерны взаимодействия с моделями. Если OpenAI удастся масштабировать эту инфраструктуру, быстрый инференс может стать конкурентным преимуществом не только для кодинга.